记一次修复安装 Magisk 模块后的 bootloop

昨天看到系统通知有 Android 10 的 OTA,就顺手把系统升级了,也知道可能有些 Magisk Module 不兼容,所以把所有的 Module 都先关闭了,升级的过程倒是非常顺利。所以也就没有多想就依次想试试 Magisk 模块能不能启用,尤其是 EdXposed。可是就是没有想到这个启用让手机停留在了 OnePlus 的开机 Logo 无限开机中。这个问题倒也不是很大,之前也就遇到过,只要刷入一个 uninstall 的包就可以了。所以就想要进入 recovery。

这里插入一下一加的几个组合按键。

- 在开机状态下 Volume Up + Boot 按键长按可以强制关机

- 在关机状态下 Volumn Down + Boot 按键长按可以进入 recovery 模式

- 在关机状态下 Volumn Up + Volumn Down + Boot 三个按键同时按住可以进入 fastboot 模式

因为之前就刷入了 TWRP 的 recovery 所以也不是很怕,但是当我进入 TWRP 的 recovery 的时候,我发现 TWRP 没有要求我输入 PIN 密码,并且进入后也无法加载 data 分区,所以手机内部的所有内容都无法读取,这一下就有点慌了,因为我不想丢失数据。经过一番搜索,尝试了重新刷 boot.img,后来发现 Android 10 的 TWRP recovery 可能需要升级,所以在 xda 上找到了 unofficial 的 Android 10 的 recovery,刷入后果然能够解锁了。

然后再把 Magisk 的 uninstall 的包刷入,开机果然就没事了。然后不甘心,从头开始,重刷了最新的 TWRP 3.3.1-xx Unified Unofficial by mauronofrio,然后刷入 Magisk,不过没有启用任何 Module,然后一个个尝试启用 Module,果然 EdXposed 启用之后还是会卡在 Logo,但是这个时候我就不需要重新刷入 uninstall magisk 的包了,我只需要进入 recovery.

- 进入 TWRP

- Advanced > File Manager > data > adb > modules

- 然后找到对应新安装的 module,进入文件夹,然后点击右下角的勾

- 在弹出的对话框中选择 Delete

再重启进入系统即可。

reference

Java 类加载器

虚拟机把描述类的数据从 Class 文件加载到内存中,并对数据进行校验、转换解析和初始化,最终形成可以被虚拟机直接使用的 Java 类型,这就是 Java 虚拟机的类加载机制。

类加载的时机,整个生命周期包括:

- Loading

- Verification

- Preparation

- Resolution

- Initialization 初始化

- Using

- Unloading

其中 Verification, Preparation, Resolution 三个部分称为 Linking。

四种情况必须对类进行“初始化”。

- 遇到 new, getstatic, putstatic 或者 invokestatic 四条字节码指令时

- 使用 java.lang.reflect 包方法对类进行反射调用时

- 初始化类时,如果发现其父类没有初始化,则需要先触发其父类的初始化 auto

- 当虚拟机启动时,用户需要指定一个执行的主类(包含 main 方法的那个类),虚拟机会初始化这个类

Loading

虚拟机会:

- 通过一个类的全限定名获取定义此类的二进制字节流偶 iu

- 将这个字节流所代表的静态存储结构转化为方法区的运行时数据结构

- Java 堆中生成一个代表这个类的 java.lang.Class 对象,作为方法区这些数据的访问入口

Verification

Linking 的第一步,为了确保 Class 文件字节流中包含的信息符合当前虚拟机的要求,并且不会危害到虚拟机自身的安全。

文件格式验证

验证字节流是否符合 Class 文件格式规划。

元数据验证

字节码描述的信息进行语义分析,以保证符合 Java 语言规范。

字节码验证

进行数据流和控制流分析。

符号应用验证

符号引用验证的目的是确保解析动作能正常执行,如果无法通过符号引用验证,会抛出一个 java.lang.IncompatibleClassChangeError 异常的子类,比如 java.lang.IllegalAccessError, java.lang.NoSuchFieldError, java.lang.NoSuchMethodError 等等。

Preparation

准备阶段正式为变量分配内存并设置类变量初始值的阶段,这些内存都将在方法区中进行分配。这个阶段中有两个容易产生混淆的概念,这个时候进行内存分配的仅仅包括类变量(被 static 修饰的变量),不包括实例变量。实例变量将会在对象实例化时随着对象一起分配在 Java 堆中。其次初始值“通常”指的是数据类型的零值。

public static int value = 123;

那么变量 value 在准备阶段后,初始化为 0 而不是 123. 但是

public static final int value = 123;

编译时 Javac 将会为 value 生成 ConstantValue 属性,在准备阶段虚拟机就会根据 ConstantValue 设置,将 value 值设置为 123.

Resolution

虚拟机将常量池内的符号引用替换为直接应用的过程。

初始化

到初始化阶段,才真正开始执行类中定义的 Java 程序代码。

初始化阶段是执行类构造器 clinit() 方法的过程。

双亲委派模型

Java 虚拟机角度,只存在两种不同的类加载器:

- 启动类加载器 Bootstrap ClassLoader , C++ 实现

- 其他类加载器,Java 实现,独立于虚拟机之外,继承抽象类 java.lang.ClassLoader.

工作过程,如果一个类加载器收到类加载的请求,将这个请求委派给父类加载器完成,每一个层次的类加载器都如此,因此所有的加载请求最终都应该传送到顶层的启动类加载器中,只有当父加载器反馈无法完成这个加载请求时,子加载器才会尝试自己去加载。 实现双亲委派的代码都在 java.lang.ClassLoader 的 loadClass() 方法中。

解压和打包 jar 并手动上传到 Nexus 记录

解压和打包 jar 包,使用如下的方式。

unpack

jar xf filename.jar

pack

jar cf filename.jar path/to/dir

手动上传到 nexus

将打包好的 jar 包上传到 Nexus

mvn deploy:deploy-file -DgroupId=my.group.id \

-DartifactId=my-artifact-id \

-Dversion=1.0.1 \

-Dpackaging=jar \

-Dfile=realfilename.jar \

-DgeneratePom=true \

-DrepositoryId=my-repo \

-Durl=http://my-nexus-server.com:8081/repository/maven-releases/

记住这里的 repositoryId 一定是 ~/.m2/settings.xml 文件中的 ID, 另外 url 也要区分一下 releases 和 snapshots.

<servers>

<server>

<id>my-repo</id>

<username>admin</username>

<password>admin123</password>

</server>

</servers>

reference

在 Linux 上测试硬盘读写速度

记录一下在 Linux 下测试硬盘读写速度的命令和方法。

dd

使用 dd 测试写速度,千万有注意 of 后接的文件必须是一个不存在的文件,否则可能造成数据丢失!

sync; dd if=/dev/zero of=/tmp/tempfile bs=1M count=1024; sync

1024+0 records in

1024+0 records out

1073741824 bytes (1.1 GB, 1.0 GiB) copied, 2.55331 s, 421 MB/s

同样的道理,如果要测试一个外部存储,需要知道挂载点,然后用 dd 命令:

sync; dd if=/dev/zero of=/media/user/MyUSB/tempfile bs=1M count=1024; sync

使用 dd 测试读取速度,注意这里的 if 后需要接上一个命令生成的文件:

dd if=/tmp/tempfile of=/dev/null bs=1M count=1024

1024+0 records in

1024+0 records out

1073741824 bytes (1.1 GB, 1.0 GiB) copied, 0.271083 s, 4.0 GB/s

清楚 cache,准确的测试真实的读速度:

sudo /sbin/sysctl -w vm.drop_caches=3

dd if=/tmp/tempfile of=/dev/null bs=1M count=1024

hdparm

使用 hdparm 也可以对硬盘进行测试。

apt install hdparm

先用 lsblk 或者 fdisk -l 来查看设备信息,一般磁盘都是 /dev/sda 这样。

然后用如下命令测试:

sudo hdparm -Tt /dev/sda

/dev/sda:

Timing cached reads: 31236 MB in 1.99 seconds = 15733.75 MB/sec

Timing buffered disk reads: 504 MB in 3.01 seconds = 167.51 MB/sec

reference

Syncthing 又一款同步工具

昨天在整理同步工具的时候接触到了 [[Syncthing]],简直秒杀了我现在使用的任何同步工具,所以不得不花一些篇幅来记录一下。

在看到 Syncthing 的介绍时,就非常好奇它的同步原理。也幸亏它的官方文档也有非常详细的 QA

几个比较重要的点:

- 和 BitTorrent/Resilio Sync 的区别在于,Syncthing 开放源代码,使用开放协议,避免 Resilio Sync 闭源协议的安全问题

- Syncthing 的同步原理,和 BT 类似,会将文件分片传输,当越多设备在线,那么共享速度越快

- Syncthing 依赖于一个全局发现服务器,用来通过 Device ID 来发现设备 IP 和 端口,任何人都可以自己架设全局 Discovery 服务器,然后将自己的节点指向该服务器,这样就不必共享全局的服务器了,更甚至不需要依赖与因特网就能够实现局域网内文件同步

- 关于安全性的说明 已经列举的非常详细了,所有内容通过 TLS 加密传输

下载安装

下载及安装过程不再赘述,官网已经非常详细了。

在 Ubuntu 下安装

Docker 安装

使用 Linuxserver 的镜像安装:

端口

Syncthing 有个端口需要注意一下

- 8384 端口是网页 GUI 监听端口,默认监听 127.0.0.1

tcp://0.0.0.0:22000服务监听地址udp://0.0.0.0:21027本地发现服务端口

配置文件

在 Unix 下在 $HOME/.config/syncthing 下

vi ~/.config/syncthing/config.xml

然后修改本地监听地址从 127.0.0.1 到 0.0.0.0.

设置 Syncthing 开机启动

如果熟悉 supervisord 可以使用官方提供的文档配置,如果在 Linux 下可以尝试使用 Systemd

sudo systemctl enable syncthing@yourname.service

sudo systemctl start syncthing@yourname.service

记得把 yourname 替换成用户名。

Syncthing 服务启动后端口是 8384.

推荐理由

推荐的理由:

- 无需额外的服务器资源,以前使用 NextCloud 的时候,有一个很不方便的便是需要保证服务器 24h 不停地在线,放在家里 NAS 如果遇到停电就很不方便

- 同步速度非常快,使用中心化的同步服务,中心服务器的网速限制了同步的速度,如果客户端越多速度越慢,但是 Syncthing 做到了点对点传输,也就意味着客户端越多那么同步速度越快,因为这一个节点的文件内容可以并行分片的从不同的节点获取

- 丰富的客户端,除了 iOS 没有官方支持,三大桌面端,Android,路由器,NAS 几乎都有支持,因为 Go 写的嘛

- Syncthing 完美的替换了 Dropbox 等等服务

Syncthing 配置本地 Discovery 服务器

有一种情况是,加入只想要在本地局域网中传输数据,那么可以关闭全局 Discovery 服务器,然后在设置中手动指定某一态服务器的 IP 和 端口,而不是使用默认的 dynamic。这样所有的数据就会在本地传输。

Syncthing File Versioning

Syncthing 支持文件的版本控制,当从 cluster 同步,删除或者同步一个新版本之后备份之前的老版本。File Versioning 是每一个文件夹,每一个设备可以单独控制的。默认情况下是 「No File Versioning」,也就意味着本地不回保存远程设备删除的文件。

Syncthing 有好几种文件版本控制策略:

- Trash Can File Versioning

- 模拟通常的垃圾箱的处理机制,当文件在远程设备上被删除或代替的时候,会将其移动到

.stversions文件夹的垃圾箱中,如果垃圾箱中已经存在同名文件,将会被替换 - 当配置 Trash Can 策略的时候可以设置清理天数,如果配置正数,则文件在设置天数之后会被清除,如果设置 0,则不会清理

- 模拟通常的垃圾箱的处理机制,当文件在远程设备上被删除或代替的时候,会将其移动到

- Simple File Versioning

- 当设置成该策略时,如果文件被远程设备删除或替换,文件将被移动到共享文件夹的

.stversions文件夹中。选择此策略之后还可以设置“保留版本”选项,告诉 Syncthing 应该保留该文件的旧版本数量。例如,如果将此值设置为 5,则在远程设备上替换文件 5 次时,在共享相同文件夹的.stversions文件夹中将看到 5 个带有时间戳的文件版本。

- 当设置成该策略时,如果文件被远程设备删除或替换,文件将被移动到共享文件夹的

- Staggered File Versioning

- 当远程设备上的文件被替换或删除时,文件也会被移动到不同的文件夹(就像“简单文件版本”一样),但是,如果版本超过了最大年龄或超过了间隔中允许的文件数量,则会自动删除版本。

- 这种版本控制策略可以指定历史版本存储的位置,默认位置为文件夹路径中的

.stversions文件夹。如果设置自定义版本路径,请确保它位于与共享文件夹路径相同的分区或文件系统上,否则移动文件可能会失败。您可以使用绝对路径(推荐)或相对路径。相对路径是相对于 Syncthing 当前或启动目录解释的。

- External File Versioning

- 这种版本控制策略是将 Syncthing 的版本控制交由外部的程序决定

Syncthing 使用过程中的一些问题

发送和接收模式

Syncthing 支持三种工作模式:1

- 发送和接收,Send & Receive Folder,这是文件夹的默认模式,对文件夹的修改会发送,其他设备的修改也会同步回来

- 仅发送 Send Only,这种模式表示仅仅将当前设备上的文件夹的改动发送到其他设备,用来隐式地表示其他同步设备上的文件不会被修改,或者其他设备上的修改可以被忽略。这种模式非常适合,将当前设备设定为工作设备,然后设定一台设备作为此设备的备份。

- 在 Send Only 模式下,集群中其他设备的修改都会被忽略,修改依然会接收,文件夹可能会出现 「out of sync」,但是没有修改会被应用到本地

- 当 Send Only 文件夹出现 out of sync,那么一个红色的 Override Changes 会出现在文件夹详情中,点击该按钮会强制将当前主机的状态同步到其他剩余节点。任何对文件的修改,都会被当前主机上的版本所覆盖,任何不存在于当前主机节点的文件都会被删除,其他类似

- 仅接收 Receive Only,这种模式下所有的修改都会被接收并应用,然后重新分发给其他使用 send-receive 模式的设备。但是本地的修改不会被分发给其他设备。这种模式适合于建立备份镜像(replication mirrors),或者备份目的主机的场景,这些情况下不期望有本地修改或者本地的修改是不允许的

- 当本地文件被删除时,Syncthing 会显示一个 Revert Local Changes 按钮。使用这个按钮会将本地的修改回撤,所有添加的文件会被删除,修改或删除的文件会重新从其他节点同步

比较容易理解,但是假如 A 设备设置仅发送,B 设备设置发送和接收,A 是不会同步 B 的更改的!

.stignore

忽略列表,和 gitignore 类似。每一台设备上的 .stignore 都是分别设置的,不会进行同步。

如果 A 的.stignore忽略了 test ,而 B 没有这样做,实际上会发生这样的事情:

- A 不会扫描和通知 B(广播)关于 test 的变动;

- B 对关于 test 的变动持开放的姿态,但不会收到任何关于 A 上面 test 的变动信息(可能接收到其它同步设备的);

- B 会扫描 test 以及推送其关于 test 变动的信息,但会被 A 忽略,A 也会忽略其它同步设备关于 test 的信息;

- B 会接收来自其它同步设备推送的关于 test 的信息;

这里有一个小提示,因为 .stignore 文件是不会同步的,每个设备都需要自行设置。如果想要同步这个配置,那么可以先创建一个 .globalstignore 文件,把需要忽略的内容写到这个文件中,然后在 Syncthing 中配置:

#include .globalstignore

一份常用的 .globalstignore:

//---Mac-specific---//

//Mac Comments, Finder Windows Size, Tags, ...

(?d).DS_Store

.DocumentRevisions-V100

//Mac Folder Icons, which will not sync to Windows

(?d)Icon*

.Spotlight-V100

.TemporaryItems

.Trashes

.fseventsd

(?d).localized

//Mac Temporary iCloud files while synching

.iCloud

//Mac OS Metadata on Windows or Linux filesystems

(?d)._*

//---Windows-Specific---//

(?d)desktop.ini

(?d)Thumbs.db

(?d)$RECYCLE.BIN

*.lnk

//---Linux-specific---//

.Trash-*

//---QNAP-specific---//

(?d).@__thumb

(?d).AppleDB

//---Synology-specific---//

(?d)@eaDir

//---Application-specific---//

//-Syncthing

(?d).stignore

(?d).stfolder

//-vi(m)

(?d)*.*.sw[a-p] # Thankys to Tom Hale!

//-Dropbox

.dropbox

.dropbox.attr

//-Microsoft Office temporary files/lock files

(?d)~*

//-KDE

.directory

//---OTHER---//

Microsoft-Benutzerdaten

Notizbuch von Wolf.url

Outlook-Dateien

RDC Connections

.parallels-vm-directory

Default.rdp

同步状态

管理后台显示的最后更改(Lastest Change)是指的,根据【别人的变动】【对自己做修改】的情况和时间。或许用英语来解释稍微易懂一些, The “Latest Change” on the folder only shows incoming changes.

管理后台显示的最后扫描或者 Last Scan 是指对【自己的目录】最后扫描的时间。

管理后台显示的 Out Of Sync 或者未同步指的是「尚未接他方推送的变动」,如果已收到对方关于变动的通知,但因为下载问题或者.stignore的设定而未能下载这些变动,就会出现这个情况。

Override Changes

Override Changes 或者撤销变动,中文译法有些不准确。出现这个提示的原因通常是设为仅发送的一方(A,master)认为自己的资料是最新的,认为对方(B)推送的变动是应该被撤销的,即使 B 关于特定资料的修订时间要晚于本地;点这个按钮会强迫 B 对方撤销自己的变动,以其收到的 A 的版本为准更改资料。

228/SECCOMP

当我在一台比较老的机器上安装 Syncthing, systemd status 发现无法启动 Syncthing,查看日志说是:228/SECCOMP 错误。

这个时候需要修改 sudo vi /lib/systemd/system/syncthing@.service,并将其中两行注释。

# SystemCallArchitectures=native

# MemoryDenyWriteExecute=true

然后重新 sudo systemctl daemon-reload,并重新启动 Syncthing:

sudo systemctl start syncthing@einverne.service

inotify limit

增加 inotify limit

添加到配置(重启后生效):

echo "fs.inotify.max_user_watches=204800" | sudo tee -a /etc/sysctl.conf

立即生效可以配置:

echo 204800 | sudo tee /proc/sys/fs/inotify/max_user_watches

Introducer 配置

在 Syncthing 的 Remote Devices 中会看到一个 Introducer 的配置,通过简单的配置选项大概能知道其作用就是用于自动添加新设备(节点)。但是 Syncthing 是以一个什么逻辑来 Introduce 新设备并没有深入的了解,这里就整理一下官方文档中关于 Introducer 部分的内容。

当两个设备连接的时候,他会会交换一个相互分享的文件列表以及设备连接到哪些共享文件夹。比如:

本地设备 L 设置了远程设备 R 作为一个 Introducer。 他们共享文件夹 “Pictures”,设备 R 还和 A 和 B 共享 “Pictures” 文件夹,但是 L 仅仅和 R 共享。 那么一旦 L 和 R 连接了,L 会自动添加 A 和 B 设备,就像 R 向 L 介绍了 A 和 B 一样 远程设备 R 和设备 C 共享 “Videos” 文件夹,但是没有和本地设备 L 共享。那么设备 C 不会被添加到 L ,因为 C 并没有和 L 和 R 的任何文件夹相连。

设备和设备的 Introduce 的过程包含着设备 IDs,标签,地址设置的自动配置,但是不包含设备本地的相关设置。设备的自动配置,仅会在连接到 Introducer 之后,或者重启时被应用一次,当设备连接到介绍器时就会完成。一旦完成自动配置,设备的设置将无法从 Introducer 那里收到任何更新。

当一个 introducer 添加或移除设备,或者修改共享文件夹,或者修改设备分享设定,这些修改会在下一次连接时被应用到设备。类似的,如果一个被介绍的设备不再出现,或者不再 fxl 共同的文件夹,该设备会自动在下一次连接是从集群(cluster)节点中被移除。

Introducer 状态是传递的,这意味着,Introducer 的 Introducer 也会成为 Introducer。

将两个设备相互设置成 Introducer 是不推荐的。当添加设备,移除设备时可能会造成问题,两个设备会相互不停的 re-introducing 移除的设备。

移动 Syncthing 同步文件夹位置

当发生空间不足,或者想要移动同步文件夹位置的时候。可以通过如下步骤完成:

- 在 Syncthing 管理后台将文件夹移除

- 然后在系统中移动文件夹内容

- 在 Syncthing 后台将文件夹添加,并指定为新的位置。

建议只在同步完成的文件夹中操作。

reference

同步工具整理总结

陆陆续续用过不少同步工具,资料备份,各个设备间同步文件,从商业化的工具到命令行工具,但总还是一直在寻找一款足于满足我所有需求的工具。这里就整理一下,顺便整理一下我自己的思路。不久前就一直在思考一个问题,数字文件的生命有多长,以前看到过一句话,几十年前父母写下的日记如今依然能从旧书柜中翻出,数十年前的胶卷照片依然还很清晰,但往往几年前的网络文章,或者数字照片可能如今随着网络服务的关闭,物理硬盘的损坏而无法恢复。有人尝试使用多地备份,有人尝试云服务备份,却都无法从根本上解决这个问题,当然现在的我依然没有办法完全的解决这个问题。

目前我从两个方面来规避这个问题,一方面物理备份一份,一方面网络存储一份。虽然可以从大部分情况下解决一些问题,不过并不能保证 100 % 数据安全。

中心化的同步工具

中心化的同步工具就像是那个时候的 SVN,使用体验完全依赖于中心服务器,网速,磁盘大小都决定了最后的使用体验。

Dropbox vs pCloud vs NextCloud

最早接触到同步工具应该就是 Dropbox 了,PC 上,手机上都是使用 Dropbox 来同步的,并且我的 Dropbox 利用率一直都还是很高。但是 Dropbox 因为网络问题原因,有些时候可能会比较慢。所以一直作为保留项目。

在 Dropbox 之后,也用过 pCloud 不过也并没有深度使用。

之后就是尝试在 VPS 上建了 NextCloud,然后买了 NAS 之后把内容备份到了 NAS 上,并且开始深度使用 NextCloud

不过以上这些工具都有一些问题,比如我都只用来同步一些相对比较小的文件,比如文件,图片,文档等等内容。因为受到同步服务器容量的限制,所以有些文件我会有意识的不同步。

去中心化的同步服务

去中心化的服务有很多,这些年陆陆续续也都用过很多。就我个人而言,如果使用命令行,我会用 rsync, 如果要有一个比较友好的界面,我会用 Syncthing。

Rsync

rsync 之前的文章 已经提到过,很多使用方法那篇文章中也有提及,这里就不赘述了。

unison

unison 没怎么用过,但是 unison 经常被用来和 rsync, syncthing 一起比较,想必也有他的过人之处。

Resilio Sync

曾经用过很长一段时间,说是去中心化的,但是国内把中心服务的节点屏蔽之后就很难连接上其他地址了,所以后来就放弃了。不过 NAS 上还一直留着,使用起来也非常不错。

如果想要分享只读大文件给很多人,不妨体验一下。

VerySync

之前也有写过一篇文章 威联通上使用 verySync,但是这个同步工具毕竟还是用的人少,并且还是国产闭源应用,可信度不高。作为 Resilio Sync 的国产代替品使用。

Syncthing

开源,跨平台,Go 语言编写,其他就不用多说了。这可能是这一次整理收获最大的一个工具。

添加 Linux 启动项,可以参考官方的文档,非常详细

这个工具足以代替 Dropbox 完成同步任务,支持增量备份,支持版本管理,各个平台都有完美的解决了同步的问题。

Other

insync 是一个可以将本地文件夹和 Google Drive 同步的工具,收费

GoodSync 又一款同步工具,支持很多平台,不过有些功能需要收费。

reference

lsb init scripts

I found someone submit a pull-request to redis, which modify the init.d script. The modification make me curious about the init script. So this is the research result.

LSB stand for Linux Standard Base.

LSB-compliant init scripts need to:

- provide, at least, the following actions: start, stop, restart, force-reload, and status.

- return proper exit status codes

- document runtime dependencies

-

[optionally] Log messages using the Init.d functions: log_success_msg, log_failure_msg and log_warning_msg

#!/bin/sh ### BEGIN INIT INFO # Provides: scriptname # Required-Start: $all # Required-Stop: # Default-Start: 2 3 4 5 # Default-Stop: 0 1 6 # Short-Description: Start daemon at boot time # Description: Enable service provided by daemon. ### END INIT INFO

解释:

- Provides 可识别名字

- Required-Start 启动此程序前要先启动那个项目

- Required-Stop 在哪一个项目前停止,可留白

- Default-Start 在哪些 run level 下启动程序 ,比如

2 3 4 5 - Default-Stop 在哪些 run level 下停止此程序,一般

0 1 6

几个虚设项目,以 $ 开头

$local_fs本地文件系统被挂载,用到/var目录的启动项都需要依赖此$network网络被启用$named名称功能被启用$remote_fs所有文件系统被挂载,包含/usr$syslog系统记录功能启用$time系统时间被设定$all所有项目

一般的 daemon 应该依赖 $remote_fs 和 $syslog ,核心模块驱动程序等,需要依赖 $local_fs

Edit

在 /etc/init.d 目录下有一个 skeleton 文件,可以以此作为文件的基础来进行编辑。

Actions

一个脚本需要提供 start, stop, restart, force-reload, status 这几个动作。

reference

支持对象存储的开源存储系统

最近整理文档,想起来自己的腾讯云,和 Google 云,好几十 G 的对象存储都空着,虽然腾讯云填了一部分同步的书籍,但是还是没有好好利用起来,然后就突然想起来之前看到过有人自己写了一份网盘同步程序,将对象存储作为同步工具来使用,这么一想确实可以尝试一下,毕竟现在 Dropbox 容量渐渐不够用了,如果能作为一份扩充也倒是不错的选择。所以这里就整理一下目前可用的一些方案,然后再做一下决择。

Cloudreve

这是一款 PHP 所写的云盘系统,支持多家对象存储,设计采用 Material Design ,看起来也不错。

ZFile

[[ZFile]] 是一款 Java 编写的在线文档分享工具。

lsky-pro

[[lsky-pro]] 是一款用 PHP 框架 [[laravel]] 编写的图片管理系统。

OneList

基于 Python 的 OneDrive 网盘目录列表

oneindex

[[oneindex]] 是一款用来展示 One Drive 列表的项目,PHP 编写。

PyOne

基于 Python 的 onedrive 文件本地化浏览系统,使用 [[MongoDB]] 缓存文件

minio

用 Go 实现了一套对象存储的服务端,兼容 AWS S3。

Piwigo

一款在线相册

在调查的过程中,还发现了日本的一个云存储服务,TeraCLOUD,提供 10G 空间,还支持 WebDAV ,果断注册一个。如果你也想注册可以注册完之后,用我的 CODE :NDMSQ

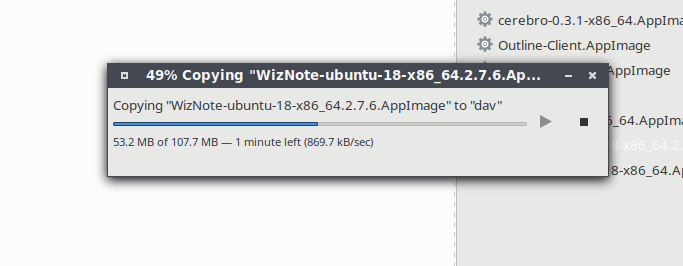

支持 [[WebDAV]] ,那么我就可以直接在我的 nemo 文件管理器 中 connect 到这个服务,在 File -> Connect to Server 中选择 Secure WebDAV(HTTPS),然后输入 TeraCLOUD 提供的 WebDAV 地址,以及用户名和密码来登录该服务,既不用多安装一个客户端,也可以非常方便的映射到本地文件管理器中。简单的测试了一下,发现上传速度,在我这里竟然达到了惊人的 800 kB/s

其他桌面版,或者移动客户端,只要支持 WebDAV 协议,那么都可以非常方便的使用该服务。官方也提供了一系列的选择方案。

Use shadowsocks libev

This post is under the environment of Ubuntu 18.04, this instruction will guide how to install shadowsocks libev both server side and client settings manually. And show the step to configure the simple-obfs.

The source code is in following two repositories:

You can manually build and install yourself. But under Ubuntu 18.04, you can just install like this:

sudo apt install shadowsocks-libev simple-obfs

and the configuration is under /etc/shadowsocks-libev/. You can manullay modify it and make it work.

If your system is before Ubuntu 18.04, you have to build it from source.

Install shadowsocks-libev via Ubuntu PPA

sudo apt-get install software-properties-common -y

sudo add-apt-repository ppa:max-c-lv/shadowsocks-libev -y

sudo apt-get update

sudo apt install shadowsocks-libev

Install simple-obfs

sudo apt-get install --no-install-recommends build-essential autoconf libtool libssl-dev libpcre3-dev libev-dev asciidoc xmlto automake

git clone https://github.com/shadowsocks/simple-obfs.git

cd simple-obfs

git submodule update --init --recursive

./autogen.sh

./configure && make

sudo make install

Make ~obfs-server~ able to listen on port 443

setcap cap_net_bind_service+ep /usr/local/bin/obfs-server

Server configuration

Add below to ~/etc/shadowsocks-libev/config.json~

{

"server":"0.0.0.0",

"server_port":443,

"local_port":1080,

"password":"password",

"timeout":300,

"method":"chacha20-ietf-poly1305",

"plugin":"obfs-server",

"plugin_opts": "obfs=tls;obfs-host=www.douban.com",

}

Start ~shadowsocks-libev~ server

systemctl enable shadowsocks-libev.service

systemctl start shadowsocks-libev.service

systemctl status shadowsocks-libev.service

Optimizations

Install & enable BBR TCP congestion control

apt install --install-recommends linux-generic-hwe-16.04

apt autoremove

modprobe tcp_bbr

echo "tcp_bbr" >> /etc/modules-load.d/modules.conf

echo "net.core.default_qdisc=fq" >> /etc/sysctl.conf

echo "net.ipv4.tcp_congestion_control=bbr" >> /etc/sysctl.conf

sysctl -p

MISC

Add below to ~/etc/sysctl.d/local.conf~

fs.file-max = 51200

net.core.rmem_max = 67108864

net.core.wmem_max = 67108864

net.core.netdev_max_backlog = 250000

net.core.somaxconn = 4096

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_fin_timeout = 30

net.ipv4.tcp_keepalive_time = 1200

net.ipv4.ip_local_port_range = 10000 65000

net.ipv4.tcp_max_syn_backlog = 8192

net.ipv4.tcp_max_tw_buckets = 5000

net.ipv4.tcp_fastopen = 3

net.ipv4.tcp_mem = 25600 51200 102400

net.ipv4.tcp_rmem = 4096 87380 67108864

net.ipv4.tcp_wmem = 4096 65536 67108864

net.ipv4.tcp_mtu_probing = 1

Reboot

reboot

Client configuration

Add below to /usr/local/etc/shadowsocks-libev.json

Note that the ~plugin~ has to be absolute path in order to be able to use ~brew services start shadowsocks-libev~.

{

"server":"SERVER",

"server_port":443,

"local_address": "127.0.0.1",

"local_port":1080,

"password":"PASSWORD",

"timeout":300,

"method":"chacha20-ietf-poly1305",

"workers":8,

"plugin":"/usr/local/bin/obfs-local",

"plugin_opts": "obfs=tls;obfs-host=www.bing.com",

"fast_open":true,

"reuse_port":true

}

reference

排查导致 CPU load 过高的 Java 线程

When you encouter the high cpu load caused by java application, you may follow these steps to troubleshooting.

identify the PID

identify the PID, use top or htop then press P, sorted by CPU

identify the thread

identify the thread using top -n 1 -H -p PID, this command will give an output listing all the threads in the selected process

like this:

KiB Mem : 16342620 total, 270500 free, 12773428 used, 3298692 buff/cache

KiB Swap: 7812092 total, 2654116 free, 5157976 used. 1999284 avail Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

28958 einverne 20 0 8824828 3.021g 23784 S 30.0 19.4 0:00.00 java

28959 einverne 20 0 8824828 3.021g 23784 S 0.0 19.4 0:00.56 java

28960 einverne 20 0 8824828 3.021g 23784 S 0.0 19.4 0:10.35 GC Thread#0

28961 einverne 20 0 8824828 3.021g 23784 S 0.0 19.4 0:00.06 G1 Main Marker

28962 einverne 20 0 8824828 3.021g 23784 S 0.0 19.4 0:07.24 G1 Conc#0

28963 einverne 20 0 8824828 3.021g 23784 S 0.0 19.4 0:00.42 G1 Refine#0

Here for example, PID 28958 use 30% of CPU.

jstack

Then use jstack to show the stack trace for the PID

jstack PID > jstack.out

Convert thread ID to Hexadecimal value

Use the above result as example, thread id 28958 is the problem thread. Then convert it to hex value. 28958 -> 711e

Here I provide an easy way to convert decimal to hexadecimal under bash:

printf '%x\n' 28958

# or

echo "obase=16; 28958" | bc

Search the stack trace output for the hex value using the tools you’re familiar with, grep, less etc.

less jstack.out

Then you will found the thread details.

reference

文章分类

最近文章

- AI Shell 让 AI 在命令行下提供 Shell 命令 AI Shell 是一款在命令行下的 AI 自动补全工具,当你想要实现一个功能,敲一大段命令又记不住的时候,使用自然语言让 AI 给你生成一个可执行的命令,然后确认之后执行。

- 最棒的 Navidrome 音乐客户端 Sonixd(Feishin) Sonixd 是一款跨平台的音乐播放器,可以使用 [[Subsonic API]],兼容 Jellyfin,[[Navidrome]],Airsonic,Airsonic-Advanced,Gonic,Astiga 等等服务端。 Sonixd 是一款跨平台的音乐播放器,可以使用 [[Subsonic API]],兼容 Jellyfin,[[Navidrome]],Airsonic,Airsonic-Advanced,Gonic,Astiga 等等服务端。

- 中心化加密货币交易所 Gate 注册以及认证 Gate.io 是一个中心化的加密货币交易所。Gate 中文通常被称为「芝麻开门」,Gate 创立于 2013 年,前身是比特儿,是一家致力于安全、稳定的数字货币交易所,支持超过 1600 种数字货币的交易,提供超过 2700 个交易对。

- 不重启的情况下重新加载 rTorrent 配置文件 因为我在 Screen 下使用 rTorrent,最近经常调试修改 rtorrent.rc 配置文件,所以想要找一个方法可以在不重启 rTorrent 的情况重新加载配置文件,网上调查了一下之后发现原来挺简单的。

- Go 语言编写的网络穿透工具 chisel chisel 是一个在 HTTP 协议上的 TCP/UDP 隧道,使用 Go 语言编写,10.9 K 星星。